Comme on l’a vu dans un post précédent portant notamment sur la loi de Pareto, dans de nombreux systèmes — réseaux, marchés financiers, concentration de richesse, catastrophes naturelles — la distribution des données ou des événements n’obéit pas une loi statistique ”normale”. La probabilité de valeurs extrêmes diminue beaucoup plus lentement que dans une telle loi. C’est le cas des extrêmes climatiques1 qui peuvent provoquer des dommages globaux irréversibles, menaçant des infrastructures, des écosystèmes, voire la survie humaine.

Nous allons voir que ces constatations remettent fondamentalement en cause l’approche généralement employée par les économistes pour tenter d’évaluer l’effort à faire pour limiter le dérèglement climatique. Elles conduisent à une approche renouvelée, fondée sur la notion de robustesse.

Ce post a été inspiré par des échanges avec Nathanaël Wallenhorst et la lecture de son livre 2049, avec Jean-Pierre Gonguet et François Lévêque, que je remercie chaleureusement. Leur responsabilité n’est en rien engagée dans les phrases qui suivent.

1. Comment comparer le coût économique de l’inaction et celui de l’action climatique ?

Les économistes, depuis les travaux précurseurs du “prix Nobel” William Nordhaus, essaient d’apprécier le coût de l’inaction (c’est-à-dire celui des dommages climatiques engendrés par les gaz à effet de serre, dans un scénario de prolongation des tendances, dit Business As Usual) et celui de l’action (le coût macroéconomique des mesures à prendre). Cette approche dite “analyse coûts-bénéfices (ou ACB)”2 leur permet d’en déduire un “optimum” (n’agir ni trop ni trop peu) qu’ils caractérisent en général par un “coût social du carbone”, que nous définirons plus loin.

Cette approche est marquée du sceau apparent du bon sens. On ne peut pas du jour au lendemain arrêter toutes les activités humaines (qui sont toutes génératrices de gaz à effet de serre) ni les remplacer par des activités neutres ou faiblement émettrices en carbone. Nous devons faire des choix collectifs de mitigation raisonnée en choisissant les actions les plus efficaces à moindre coût.

Ceci étant dit, les difficultés de l’exercice sont immenses. Nous n’en citerons que quelques-unes (voir la fiche The Other Economy sur les liens entre réchauffement climatique et croissance du PIB, plus exhaustive sur ces méthodes). Comment évaluer des dommages complexes et interdépendants à un horizon lointains ?

Nous reviendrons ici sur cette première question. Notons à ce stade que les économistes utilisent des fonctions de dommage3 qui relient la température moyenne planétaire au PIB ou au capital économique. Comment comparer les unités économiques de demain et celles d’aujourd’hui ? La méthode habituellement retenue consistant à retenir un taux d’actualisation pose de nombreux problèmes et repose en fait sur des choix éthiques et politiques. Comment répartir équitablement les efforts entre pays en intégrant un principe de responsabilités différenciées ? Comment répartir les efforts de mitigation dans la durée, sachant que certaines technologies progressent et qu’il peut être utile d’attendre qu’elles soient compétitives et qu’il existe par ailleurs des risques de verrouillage dans des technologies carbonées ? Peut-on représenter l’économie dans son ensemble par un “agent représentatif”4 ?

L’analyse coûts-bénéfices a des limites, qui semblent largement dépassées pour apporter une solution rationnelle à la question posée.

Mais nous allons ici oublier provisoirement la majorité de ces difficultés pour nous concentrer sur un problème de principe qui nous semble essentiel (évoqué dans la fiche citée plus haut), lié au caractère non-linéaire des impacts du climat, en particulier du fait de l’existence de ”points de bascule” et du risque de catastrophe majeure. Nous allons voir que ce constat, mis en évidence par l’économiste Martin Weitzman dès 20095, conduit à adopter des approches entièrement nouvelles, qu’on peut qualifier de robustes, par opposition aux approches d’optimisation qui caractérisent l’ ACB.

2. Non-linéarités climatiques et points de bascule

Le système climatique n’est pas un système linéaire répondant proportionnellement aux forçages6 externes. Il s’agit d’un système dynamique complexe, composé de sous-systèmes couplés (océan, atmosphère, cryosphère, biosphère) présentant des rétroactions positives, des seuils critiques et des transitions abruptes. Cette architecture implique que de petites variations continues des paramètres de contrôle — concentration de CO₂, flux d’eau douce, albédo — peuvent provoquer des changements qualitatifs majeurs de l’état du système.

Ces phénomènes sont aujourd’hui regroupés sous le terme de points de bascule climatiques (climate tipping points7). Un point de bascule n’est pas un choc qui bouleverse le système,

c’est un moment où le système perd sa capacité à revenir à son état habituel. Il est en général défini comme un seuil qui, lorsqu’il est franchi, entraîne de grands changements, souvent irréversibles à l’échelle humaine, qui modifient qualitativement l’état ou l’évolution du système Terre. Pour mieux comprendre ce dont il est question, on peut se représenter un sous-système climatique, une calotte glaciaire ou une circulation océanique, comme une bille évoluant sur un “paysage de stabilité”. Tant que le climat reste dans une “vallée” de ce paysage, une perturbation (année chaude, sécheresse, apport d’eau douce) déplace le système mais il revient vers son état antérieur : c’est un état stable ; au sommet d’une crête, la moindre perturbation l’en fait basculer durablement : c’est un état instable.

Parmi les exemples les plus étudiés – dont les probabilités à ce stade sont cependant différentes – on peut citer entre autres8 :

- l’effondrement de la convection des mers du Labrador et d’Irminger

- la disparition de la circulation méridienne de retournement de l’Atlantique (AMOC),

- la stabilité des calottes glaciaires du Groenland et de l’Antarctique occidental,

- la fonte de la banquise arctique et les rétroactions d’albédo,

- le dépérissement des forêts tropicales et boréales,

- le dégel du pergélisol et la libération consécutive de gaz à effet de serre.

- etc…

Des travaux récents montrent que plusieurs de ces éléments pourraient être plus proches de leur seuil critique qu’on ne le pensait auparavant, et que des interactions entre points de bascule peuvent produire des effets en cascade, amplifiant le risque systémique.9

Sur le plan mathématique, ces phénomènes relèvent de la théorie des systèmes dynamiques non linéaires, et plus précisément de la théorie des bifurcations.10 Une bifurcation correspond à une modification qualitative du comportement d’un système lorsque l’un de ses paramètres varie : disparition ou apparition d’états stables, changement de régime, hystérésis.

| Points de bascule climatiques : l’exemple de la bifurcation selle–nœud Les points de bascule climatiques peuvent être formalisés mathématiquement, grâce à la théorie des bifurcations. Parmi les différents types de bifurcations possibles11, la bifurcation selle–nœud constitue le schéma mathématique le plus simple pour représenter un basculement irréversible du système climatique. C’est pourquoi elle occupe une place centrale dans la littérature sur les tipping points et nous allons la présenter ici à titre pédagogique, pour en tirer une leçon économique. La bifurcation selle–nœud s’écrit mathématiquement ainsi : Où x est une variable d’état du système (par exemple l’intensité d’une circulation océanique, l’étendue d’une calotte glaciaire ou un indicateur agrégé de stabilité climatique) et μ un paramètre de contrôle lentement variable (forçage radiatif, température moyenne globale, apport d’eau douce, etc.). Le système se comporte différemment selon le signe de μ. – Si μ>0 , le système possède deux points fixes : * Un état stable (nœud) : si la variable d’état x atteint ce point de petites perturbations ne lui font pas quitter cet état. * Un état instable (selle) : où de petites perturbations suffisent à lui faire quitter cette position – Lorsque μ=0 les deux points fixes fusionnent : le système devient structurellement instable. – Si μ<0 il n’existe plus aucun état d’équilibre : l’état stable a disparu. Dans un processus conduisant à une bifurcation selle–nœud, le paramètre μ diminue. La “vallée” correspondant à l’état climatique stable et la “crête” instable voisine se rapprochent à mesure que le réchauffement progresse, jusqu’à disparaître ensemble. Au-delà de ce point de bascule, l’état climatique antérieur n’existe plus : même si le forçage cesse d’augmenter, le système évolue irréversiblement vers un nouveau régime. Applications climatiques : points de non-retour et irréversibilité La bifurcation selle–nœud est le schéma standard utilisé pour modéliser des points de bascule irréversibles dans le système climatique, notamment l’effondrement de la circulation méridienne de retournement de l’Atlantique (AMOC) et la perte irréversible de grandes calottes glaciaires. Dans ces cas, le système ne devient pas progressivement plus instable : il cesse soudainement d’avoir un état stable. Cette propriété est cruciale pour l’analyse économique du risque climatique car elle invalide toute extrapolation marginale des dommages. |

Un élément essentiel mis en évidence par la littérature récente est que ces transitions peuvent être déclenchées non seulement par le franchissement lent d’un seuil (bifurcation-induced tipping), mais aussi par du bruit (au sens statistique) « noise-induced tipping” ou par la vitesse du changement des paramètres (rate-induced tipping), ce qui complique encore l’anticipation et la gestion du risque.12

Ces propriétés suffisent à invalider l’idée selon laquelle les impacts climatiques seraient bien approximés par des fonctions de dommages lisses et convexes, généralement utilisées dans les modèles. Elles supposent en effet une relation continue et croissante des dommages économiques avec l’aggravation du changement climatique, sans sauts ni transitions abruptes, ce qui est contraire aux remarques faites ici.

3. Des non-linéarités aux distributions à queues épaisses

Les non-linéarités dynamiques du système climatique ont une conséquence directe sur la structure statistique des événements extrêmes. En effet, à mesure qu’un sous-système climatique approche d’un seuil critique — par exemple l’affaiblissement de la circulation méridienne de retournement de l’Atlantique (AMOC), la déstabilisation d’une calotte glaciaire ou la perte saisonnière de la banquise arctique — sa résilience diminue. Les mécanismes de rétroaction positive (glace-albédo, stratification océanique, rétroactions hydrologiques ou biosphériques) amplifient alors les perturbations. Il en résulte une augmentation de la variance13, un ralentissement du retour à l’équilibre et un allongement des corrélations temporelles (critical slowing down14). Les fluctuations ne sont plus symétriques autour d’un état moyen, mais deviennent de plus en plus biaisées vers des “excursions” extrêmes.

Statistiquement, cette dynamique se traduit par des distributions fortement asymétriques, dont les queues décroissent lentement : les événements rares mais très intenses — vagues de chaleur exceptionnelles, précipitations extrêmes, sécheresses prolongées ou ruptures abruptes de régimes climatiques — acquièrent une probabilité disproportionnée par rapport à une distribution gaussienne. Ces extrêmes sont alors bien décrits par des distributions de valeurs extrêmes généralisées (GEV en anglais)15 à paramètre de forme positif, ou par des lois à queue épaisse de type puissance.

De nombreuses études empiriques récentes confirment que les distributions des événements climatiques extrêmes — vagues de chaleur, précipitations intenses, crues, sécheresses — présentent des queues lourdes, souvent bien décrites par des lois de Pareto ou des GEV. Par exemple, des analyses hydrologiques récentes montrent que les pics de crue suivent des distributions à longue traîne, impliquant une probabilité non négligeable d’événements très au-delà des niveaux historiquement observés.16 Des résultats similaires ont été obtenus pour les extrêmes de précipitations à haute résolution, où des analyses de maxima horaires issus d’un grand ensemble de modèles climatiques régionaux montrent que la fréquence et l’intensité des pluies extrêmes courtes durées augmentent de manière significative avec le réchauffement, suggérant des distributions à queue lourde pour ces événements rares.17

Ces distributions ne sont pas de simples artefacts statistiques : elles reflètent la structure physique sous-jacente du système, marquée par l’hétérogénéité spatiale, les rétroactions positives et la multiplicité des régimes dynamiques. Dans un tel contexte, la probabilité d’événements extrêmes décroît lentement selon une loi de puissance.

Ces constats ont des implications majeures. Il signifie que certaines trajectoires de réchauffement ou de perturbation climatique, même faiblement probables, peuvent entraîner des dommages globaux irréversibles, affectant les infrastructures, les écosystèmes, la stabilité économique et, dans les cas extrêmes, l’habitabilité de la planète. Dans un tel cadre, raisonner en termes d’impact moyen ou de dommage marginal devient trompeur. Ainsi, les queues épaisses ne sont pas un détail statistique secondaire, mais l’expression probabiliste des non-linéarités physiques du système climatique.

4. Le coût social du carbone

L’analyse coûts-bénéfices que nous avons évoquée en introduction se résume, dans la recherche économique classique sur le climat, par le concept central de coût social du carbone (CSC, en anglais SCC, Social Cost of Carbon). Il s’agit du coût économique actualisé (voir la fiche actualisation de The Other Economy) généré par l’émission d’une tonne supplémentaire de CO₂, intégrant l’ensemble des impacts du climat sur l’économie. La ”consigne” économique qui en découle c’est qu’il est souhaitable de réduire les émissions de CO2 aujourd’hui tant que le coût de cette réduction est inférieur au CSC et que cela ne l’est plus quand il supérieur. Calculé à partir de modèles intégrés climat-économie, le CSC est supposé guider la politique publique : il sert de base à la fixation de taxes carbone ou de quotas d’émissions, en traduisant les “externalités climatiques” en signaux monétaires exploitables par le marché. De nombreuses évaluations de ce CSC ont été faites dans les dernière décennies.18 Elles varient de deux ordres de grandeur (de quelques dizaines de dollars par tonne de CO2 à plus de 1000 dollars), ce qui montre bien le niveau d’incertitude théorique et pratique autour de ces questions.

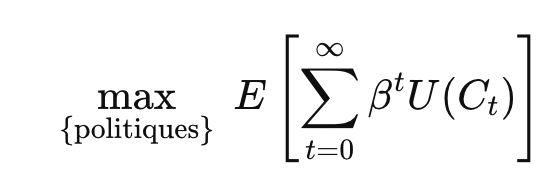

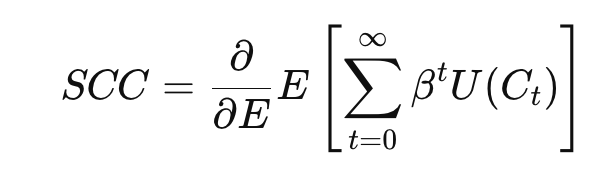

Formellement, dans ces modèles, on cherche à maximiser l’utilité espérée inter temporelle de la consommation mondiale :

où Ct est la consommation globale à l’année t, β le facteur d’actualisation, et U la fonction d’utilité. et E l’espérance mathématique, étant entendu qu’il s’agit d’un calcul statistique. Le CSC correspond alors à la dérivée marginale de cette utilité par rapport aux émissions : de combien la consommation future sera affectée demain quand on évite une tonne de CO₂ aujourd’hui.

Cependant, comme l’a souligné très tôt19, l’économiste Martin Weitzman20, ce calcul repose sur des hypothèses cruciales : les dommages climatiques doivent être bornés, et les probabilités d’événements extrêmes doivent décroître rapidement. Si ces conditions ne sont pas respectées et que certains événements sont irréversibles — le CSC devient infini. En d’autres termes, l’approche classique n’est pas conçue pour traiter correctement les risques catastrophiques, et la logique marginale de prix échoue lorsque l’enjeu est la survie ou la catastrophe globale.

Martin Weitzman a d’ailleurs forgé un théorème21 qu’il a qualifié lui-même de lugubre car sans solution pratique à ses yeux. Son théorème démontre l’impossibilité devant l’incertitude des queues épaisses de recourir au calcul standard de l’espérance mathématique des pertes. Or nous venons de voir précédemment que, les événements extrêmes climatiques n’étaient non seulement pas à exclure mais que leur probabilité ne décroissait pas rapidement.

5 Le “backstop miracle” : techno-optimisme et illusions de filet de sécurité

Pour répondre à cette critique fondamentale, les économistes modélisant les effets du dérèglement climatique sur l’économie ont recours dans leurs modèles à un « backstop » explicite ou implicite, technologique ou non (voir encadré ci-dessous).

Il s’agit de dispositifs futurs, quasi inépuisables et accessibles au plan économique qui seraient capables de résoudre le problème climatique même si la transition actuelle tarde ou déraille. Dans les modèles intégrés classiques la hausse des coûts marginaux de réduction des émissions éventuelles est ainsi toujours limitée.

| La nécessité de backstop dans les systèmes complexes et en économie du climat Un backstop22 est un mécanisme de dernier recours qui ne fonctionne qu’en cas de crise et assure la stabilité d’un système lorsque ses règles ordinaires échouent. Dans les systèmes techniques (réseaux électriques, réacteurs nucléaires, structures mécaniques), financiers ou informatiques, il se traduit par des réserves, redondances ou marges de sécurité qui empêchent des défaillances locales de se propager en effondrement systémique. La leçon est générale : tout système complexe reposant sur la coordination et la confiance est fragile sans backstop, et un système optimisé sans marge de sécurité devient cassant. En économie du climat, la notion de backstop prend un sens similaire. Certains modèles tiennent compte (voir partie 7) du recours éventuel à un backstop technologique, un substitut énergétique zéro-carbone, disponible en quantité illimitée à un coût exogène élevé mais décroissant dans le temps. Cette hypothèse borne les coûts d’abattement suffisamment pour éviter la divergence du CSC. D’autres, comme on le verra, procèdent d‘une manière plus sophistiquée, qui conduit au même résultat. On comprend vite que ces approches reposent plus sur des hypothèses ad hoc que sur des certitudes avérées ; or ce qui est en jeu est existentiel : c’est l’habitabilité de la planète. On verra en partie 8 que de nouvelles approches sont à considérer pour tenir compte de manière plus solide du théorème sinistre de Weitzman. |

Le modèle DICE – le plus important, à la fois comme référence historique et parce qu’il est toujours utilisé, par Nordhaus et d’autres économistes, dans diverses versions – fait appel à un backstop technologique. Ce “backstop miracle” est séduisant parce qu’il permet de penser que les innovations technologiques – énergie propre, capture du carbone, réseaux intelligents – viendront à bout du problème sans remettre fondamentalement en cause nos modes de production et de consommation. Il repose sur la croyance que l’innovation fera ce que la réglementation ou la transformation sociale seule ne peuvent pas faire. Il va de soi que l’introduction de ce backstop rend inutile la discussion sur les risques majeurs et leur incertitude. Malheureusement il s’agit d’une grave illusion.

6. Les limites du backstop technologique en pratique

Plusieurs raisons montrent que ce pari est loin d’être assuré :

6.1 Des solutions incertaines et potentiellement insuffisantes

Les technologies souvent citées comme promesses de backstop – comme la capture et séquestration directe du carbone, la géo ingénierie, la fusion nucléaire – sont loin d’être au point, ni au plan technique ni au plan économique, et ne sont pas exemptes d’effets secondaires encore mal connus et difficiles à prévoir. Leur efficacité réelle à l’échelle globale reste plus qu’incertaine. Dans certains cas (comme la capture directe du carbone de l’air, DAC) certaines limites sont physiques et liées aux lois de la thermodynamique. Dans d’autres cas, les limites physiques sont relatives aux matériaux critiques. Aucun backstop ne peut annuler ces contraintes physiques.

6.2 Aucun déploiement à grande échelle d’une solution technologique n’est instantané

A supposer qu’une technologie se dégage, elle supposera de construire des infrastructures – qu’il s’agisse d’énergie nucléaire décarbonée, de réseaux de capture et de stockage du carbone, ou de technologies encore émergentes – ce qui prendra des décennies. Cela contraste avec la rapidité à laquelle les tipping points climatiques peuvent produire des effets irréversibles.

Contrairement à un prêteur en dernier ressort qui peut injecter de la liquidité rapidement, aucune technologie ne se déploie à la vitesse d’un signal monétaire.

6.3 Effet rebond

L’histoire des technologies d’efficacité montre qu’elles peuvent engendrer un effet rebond, où les gains d’efficacité conduisent à plus de consommation plutôt qu’à moins d’émissions nettes, réduisant l’effet attendu de la technologie.

6.4 La dissuasion de la mitigation

Penser que les innovations technologiques viendront à temps peut aussi conduire à reporter les efforts immédiats de réduction des émissions. C’est l’effet “mitigation deterrence” (dissuasion de la mitigation) : la croyance en la possible efficacité d’options technologiques – non prouvées à ce jour- peut conduire à limiter l’ambition. Cela concerne la géo ingénierie, les technologies d’émissions négatives (captage et stockage du CO₂, DAC, BECCS) et même l’adaptation au changement climatique : investir dans l’adaptation (digues, climatisation, agriculture résistante, etc.) pourrait faire oublier la mitigation.

7. Les baskstops dans les modèles IAMS les plus utilisés en ACB

Les ACB appliquées au changement climatique reposent principalement sur un noyau restreint de modèles d’évaluation intégrée (Integrated Assessment Models, IAMs23), qui combinent dynamique économique, trajectoires d’émissions et réponse climatique afin d’estimer le coût social du carbone, y compris dans des scénarios de réchauffement élevé. Les trois modèles de référence dans ce cadre sont DICE, FUND et PAGE, qui apportent des réponses distinctes, explicites ou implicites, aux difficultés soulevées par Weitzman concernant les risques catastrophiques et les queues épaisses, et qui mettent en évidence le lien crucial entre réduction des émissions et limitation des dommages.

Le modèle DICE24, élaboré par William Nordhaus, traite la question de la faisabilité et de la non-divergence en introduisant explicitement une technologie de backstop. Celle-ci représente un substitut énergétique zéro-carbone, disponible en quantité illimitée à un coût exogène élevé mais décroissant dans le temps. Ce backstop n’est pas décrit physiquement mais joue un rôle central. En réduisant suffisamment tôt les émissions, DICE limite la hausse de température et, par conséquent, les dommages climatiques et leur coût. Ainsi, le backstop technologique agit non seulement comme un mécanisme de dernier recours pour les coûts d’atténuation, mais aussi comme un backstop dynamique qui empêche les dommages de devenir excessifs ou infinis, maintenant le CSC dans une plage finie et calculable.

Le modèle FUND, élaboré par Richard Tol adopte une approche plus indirecte. Il ne représente pas explicitement une technologie de dernier recours, mais introduit les coûts d’abattement via des fonctions de coût réduites, calibrées à partir de la littérature technico-économique. Ces fonctions imposent de facto une limite à la hausse du coût marginal d’abattement et, en agissant suffisamment tôt sur les émissions, permettent de prévenir une augmentation excessive de la température et des dommages associés. Le backstop est donc implicite : il résulte des hypothèses fonctionnelles retenues et de la limitation des dommages par la régulation des émissions, plutôt que de la modélisation explicite d’une technologie sans carbone. Ce mécanisme intégré permet d’éviter toute explosion des coûts ou du CSC, tout en conservant une logique ACB standard.

Le modèle PAGE25 développé par Chris Hope se distingue par sa réponse probabiliste aux risques extrêmes. PAGE ne recourt ni à un backstop technologique explicite, ni à un plafond direct des coûts d’abattement. La non-divergence du CSC est assurée par un ensemble d’hypothèses structurelles : des dommages climatiques explicitement bornés (en fraction du PIB), des distributions de probabilité tronquées pour les paramètres climatiques et économiques, des catastrophes modélisées comme des chocs discrets de taille finie, un horizon temporel limité et un taux d’actualisation positif mais faible. Dans ce cadre, limiter les émissions à temps agit comme un backstop dynamique : en réduisant la probabilité et l’ampleur des événements catastrophiques, la politique d’abattement précoce empêche les dommages de diverger et maintient le CSC calculable. PAGE reconnaît ainsi les incertitudes et les queues épaisses, mais les intègre dans un cadre probabiliste qui exclut par construction les pertes infinies.

En résumé, alors que DICE répond à l’argument de Weitzman par une borne technologique explicite, FUND par des bornes implicites sur les coûts et la régulation précoce des émissions, et PAGE par des bornes probabilistes sur les dommages et un mécanisme de limitation dynamique des risques catastrophiques. Les trois modèles conservent une logique ACB standard. Tous sont construits pour que le CSC reste fini. C’est ce qui explique également pourquoi ces modèles n’impliquent pas nécessairement des politiques climatiques “robustes” fondées sur des interdictions ou des contraintes absolues, mais plutôt des instruments graduels de type prix du carbone, même dans des scénarios de réchauffement élevé.

8. Les approches robustes, une option pour sortir de l’impasse

C’est ici qu’interviennent les approches dites robustes. 26

8.1 Approches robustes et analyses coûts-bénéfices

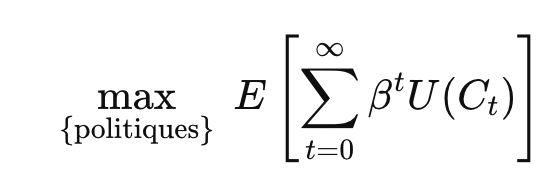

Plutôt que d’optimiser une espérance d’utilité calculée sur un scénario probabilisé, ces méthodes cherchent à protéger le système contre les pires scénarios plausibles. La formulation générale du problème à résoudre peut s’écrire mathématiquement ainsi :

Où P est un ensemble de distributions plausibles et admissibles (non comprises donc celles qui conduisent à un scénario climatique inacceptable). L’objectif est de choisir la meilleure politique P parmi un ensemble P de politiques admissibles. Il s’agit de maximiser au sein de ces politiques, l’espérance de l’utilité minimale de chacun des scénarios.

Pour chaque politique P, les conséquences économiques et climatiques futures sont incertaines et représentées par une distribution probabiliste. La somme

représente le bien-être cumulatif actualisé, où U(Ct) est la fonction d’utilité de la consommation à chaque période t et βt le facteur d’actualisation. Ce mécanisme actualise le futur, donnant moins de poids aux périodes lointaines, mais en considérant un horizon infini, on prend en compte l’ensemble des conséquences à long terme.

Le terme

correspond à l’espérance sous cette distribution, et la présence du min traduit que l’on considère le scénario le plus défavorable. Cette structure reflète une logique de prudence maximale, proche de l’argument de Weitzman sur les queues épaisses et les risques climatiques extrêmes.

L’interprétation économique de l’approche robuste est que la politique optimale doit maximiser le bien-être social dans le pire scénario plausible. Elle formalise ainsi un choix de politique fondé sur la prudence face à l’incertitude profonde, en intégrant explicitement les risques extrêmes et le long terme, tout en conservant une logique économique d’allocation des ressources. Cette formulation mathématique du principe de précaution étendue relie directement émissions, dommages et bien-être futur.

Dans ce cadre, souvent qualifié de Robust Decision Making (RDM), le coût social du carbone n’est plus un simple coût marginal : il devient conditionnel au respect d’une zone sûre, excluant les trajectoires conduisant à une ruine globale. À mesure que l’on s’approche d’une frontière catastrophique, le coût marginal croît fortement, ce qui justifie l’introduction de contraintes, de normes, voire d’interdictions ciblées sur certaines activités à forte intensité carbone. Le CSC conserve un rôle d’arbitrage à l’intérieur de cette zone sûre, mais cesse d’être l’instrument central de gestion du risque existentiel.

8.2 Approches robustes “élargies”

Ces approches robustes ne se limitent pas fondamentalement à l’usage “encadré” de l’analyse coûts-bénéfices, tel qu’on vient de le voir. Elles englobent l’approche du type de celle qui a été proposée par une équipe du FMI et que nous avons présentée dans ce blog dans un article intitulé La Nature au cœur du raisonnement économique : l’émergence d’une nouvelle macroéconomie. Il s’agit de sortir de la logique d’optimisation27 et de se préoccuper prioritairement de la capacité de nos systèmes socio-économiques à résister face aux fluctuations à venir.

Conclusion

Les lois de puissance s’appliquent aussi aux catastrophes climatiques. L’économie classique du climat et les modèles utilisés sont inadaptés car ils appliquent des hypothèses de bornes (éventuellement via l’introduction d’un backstop hypothétique) et de lois de probabilités “normales” aux queues fines.

Les approches robustes permettent de combiner prudence (interdictions, normes, planification) pour éviter la catastrophe, et raisonnement économique. Dans un monde à queues épaisses et longues traînes, le rare peut dominer la moyenne. Comme dans la finance, il faut prévoir le pire et assurer le maintien de l’habitabilité pour les humains de notre planète.

Alain Grandjean

- Température, précipitations, neige et glace, sécheresse, vent et tempêtes… ↩︎

- Voir par exemple https://www.ipp.eu/methodes/analyse-cout-benefice ainsi que la fiche The Other Economy sur l’analyse coûts-bénéfices et ses limites. ↩︎

- Voir la fiche de The Other Economy, pour la partie “Définition de la fonction de dommage, ou comment rendre le réchauffement climatique inoffensif pour la croissance économique” et cette recension d’Alain Grandjean et Marion Cohen Recension des publications récentes sur l’évaluation des dommages climatiques, Avril 2025 ↩︎

- Voir le post Loi de Pareto, bulles financières et oligopoles. La révolution des lois de puissance en économie au paragraphe 8 ↩︎

- On Modeling and Interpreting the Economics of Catastrophic Climate Change, The Review of Economics and Statistics (2009) 91 (1): 1–19. ↩︎

- En climatologie, le forçage est un facteur qui modifie l’équilibre énergétique de la Terre, provoquant un réchauffement ou un refroidissement du climat. Il peut être naturel, comme les éruptions volcaniques ou les variations de l’activité solaire, ou d’origine humaine, comme les émissions de gaz à effet de serre ou la déforestation. ↩︎

- Voir cette étude parue dans Nature Lenton TM, Rockström J, Gaffney O, Rahmstorf S, Richardson K, Steffen W, Schellnhuber HJ. Climate tipping points – too risky to bet against. Nature. 2019. Et ce rapport plus récent : The global tipping points report 2025. ↩︎

- Voir le contenu de Wikipedia sur les points de basculement climatique ↩︎

- Voir Trajectories of the Earth System in the Anthropocene. Will Stefen et al. PNAS. 2018 et Wunderling et al. Interacting tipping elements increase risk of climate domino effects under global warming, Earth Syst. Dynam.2021. ↩︎

- Voir cette présentation introductive deJulien Baglio d’après le cours de Joseph Zyss ↩︎

- On peut citer les plus connues, la bifurcation de Hopf et la bifurcation Cuspide.

Voir Kuehn, A mathematical framework for critical transitions: Bifurcations, fast–slow systems and stochastic dynamics, in Physica D: Nonlinear Phenomena, Volume 240, Issue 12, 2011.

Voir Ashwin et al., P., Wieczorek, S., Vitolo, R., & Cox, P. Tipping points in open systems: bifurcation, noise-induced and rate-dependent tipping. 2012. ↩︎ - id Note 8 – Voir le contenu de Wikipedia sur les points de basculement climatique. ↩︎

- La variance est une mesure statistique de la dispersion des valeurs d’une variable autour de sa moyenne. Par exemple, deux régions peuvent avoir la même température moyenne estivale, mais celle où les températures quotidiennes varient fortement entre jours frais et vagues de chaleur présentera une variance plus élevée, indiquant une plus grande variabilité climatique. ↩︎

- L’allongement des corrélations temporelles désigne le fait qu’un système proche d’un point de bascule met de plus en plus de temps à revenir à l’équilibre après une perturbation. On peut l’illustrer par une bille dans un bol : tant que le bol est bien creux, la bille revient vite au centre, mais si le bol devient presque plat (proche d’un seuil), la bille oscille lentement et conserve longtemps la trace des perturbations, ce qui augmente la corrélation entre états successifs. Dans le climat, ce phénomène a par exemple été étudié pour l’AMOC : à mesure qu’elle s’affaiblit sous l’effet d’apports d’eau douce, les indicateurs comme l’autocorrélation et la variance de certaines séries océaniques augmentent, suggérant un ralentissement de la dynamique et une proximité possible d’un point de bascule. ↩︎

- Les distributions de valeurs extrêmes généralisées (GEV) sont une sorte de généralisation des lois de puissance. Elles décrivent le comportement statistique des événements les plus extrêmes d’une variable (maxima ou minima) et se caractérisent notamment par un paramètre de forme. Lorsque ce paramètre de forme est positif, la distribution est de type Fréchet, ce qui signifie que la probabilité d’événements extrêmes décroît lentement et que des valeurs très grandes restent possibles, sans borne supérieure théorique. En climatologie, ce type de GEV est souvent utilisé pour modéliser les précipitations extrêmes ou les crues, où des épisodes exceptionnellement intenses, bien que rares, peuvent survenir. Par exemple, l’analyse des maxima annuels de pluies journalières dans certaines régions tropicales conduit fréquemment à un paramètre de forme positif, indiquant un risque non négligeable d’événements pluviométriques extrêmes d’intensité très élevée. ↩︎

- Voir Salah El Adlouni et al. Climatic a priori information for the GEV distribution’s shape parameter of annual maximum flow series, Journal of Hydrology, vol. 661, 2025. ↩︎

- Jayaweera, L. et al. Evaluation and projection of extreme rainfall from a large ensemble of high-resolution regional climate models in Australia. Weather and Climate Extremes, 50, 100818. 2025. ↩︎

- Voir par exemple ce récent papier de l’économiste R. Daniel Bressler Breaking Down the Mortality and Social Cost of Carbon. ↩︎

- Id note 2 – Voir par exemple https://www.ipp.eu/methodes/analyse-cout-benefice ainsi que la fiche de The Other Economy sur l’analyse coûts-bénéfices et ses limites. ↩︎

- Notons que Martin Weitzman n’est pas un théoricien de l’effondrement mais de la décision en incertitude radicale, ce monde de l’ignorance des probabilités précises des événements et des “inconnues inconnues” . Les “inconnues inconnues” (unknown unknowns) désignent des événements ou mécanismes dont on ignore à la fois l’existence et la probabilité : ce sont des risques que l’on ne sait même pas formuler à l’avance. Contrairement aux “connues connues” (événements identifiés et probabilisables) ou aux “connues inconnues” (événements identifiés mais dont la probabilité est incertaine), les inconnues inconnues échappent aux cadres probabilistes classiques. ↩︎

- Voir cet article de Charlotte Gardes (BSI economics) sur les apports de Martin Weitzman « Pourquoi l’économiste doit-il porter attention aux scénarios extrêmes de changement climatique ? » ↩︎

- Voir le post Crises bancaires et financières : le rôle du prêteur en dernier ressort où nous avons présenté cette notion appliquée à la finance. ↩︎

- Pour une présentation critique des IAMs voir ces deux notes :

Alain Grandjean, Les modèles IAMs et leurs limites, Chaire Energie et Prospérité, 2024

et Alain Grandjean et Gaël Giraud, Comparaison des modèles météorologiques, climatiques et économiques, 2017. ↩︎ - Voir cet article de Lint barrage et William Nordhaus publié en 2024. ↩︎

- Voir Hope, Chris W. The Social Cost of CO₂ from the PAGE09 model. Economics Discussion Papers, No. 2011-39, Kiel Institute for the World Economy (2011). ↩︎

- Une approche alternative, le minimax-regret (MMR), vise à minimiser l’écart maximal entre la politique adoptée et la meilleure politique a posteriori. Voir par exemple cet article : A quantitative minimax regret approach to climate change: Does discounting still matter? Ecological Economics. (2010). Bien qu’utile pour limiter le regret dans des scénarios graves, elle ne garantit pas que les catastrophes extrêmes soient évitées. Elle ne se confond donc pas avec les approches robustes, qui elles visent explicitement à protéger le système contre le pire scénario plausible. ↩︎

- Voir les travaux d’Olivier Hamant, son TEDx La révolution de la robustesse et son livre “La troisième voie du vivant » Odile Jacob, 2022. ↩︎

Image : Venezia, Veneto, Italia – Giovanni – Pexels – libre de droits

Laisser un commentaire