La règle des 80/20, dite “loi de Pareto” (voir encadré), est largement utilisée en entreprise en tant que pratique opérationnelle. Elle permet d’identifier ce qui a le plus d’impact afin de concentrer les efforts sur les actions les plus utiles. Nous allons voir ici que derrière cette règle se cache une logique, observable dans des contextes aussi variés que la culture, la finance ou l’organisation industrielle. Ces contextes sont riches de distributions de données, où quelques éléments dominent, tandis qu’une majorité forme une “longue traîne”. Cette régularité renvoie à une structure statistique générale : les lois de puissance1.

Nous allons montrer dans la suite comment les lois de puissance façonnent la dynamique économique contemporaine. Du constat empirique de Pareto à la domination des blockbusters, en passant par la formalisation des réseaux dits “invariants d’échelle”, celle des bulles financières et la formation des oligopoles, nous verrons que la concentration des ressources, de l’attention et des parts de marché n’est pas accidentelle, mais structurelle. Nous donnerons des exemples concrets issus du cinéma, de l’édition, de la musique ou du sport professionnel, puis nous présenterons des modèles issus de la science des réseaux, notamment celui de Barabási–Albert, qui permettent de comprendre comment les phénomènes de “winner takes all” émergent et se stabilisent. Nous appliquerons ces raisonnements aux mondes de la finance et de la formation des bulles financières et à celui de l’économie industrielle, à celui des médicaments et à la formation des oligopoles. Les lois de puissance apparaissent alors non comme une anomalie ou comme une curiosité mathématique, mais comme une clé de lecture essentielle des économies contemporaines.

Cette note a bénéficié des commentaires de Paul-Henri Roméo. Sa responsabilité n’est bien sûr pas engagée dans ce document.

| Loi de Pareto : d’une règle empirique à la structure des systèmes économiques Dans de nombreux contextes professionnels, une règle empirique simple est devenue un outil courant de décision et de priorisation : la règle des 80/20. Les praticiens du management, du marketing, de la logistique ou de l’ingénierie l’utilisent quotidiennement, souvent sans se préoccuper de son origine théorique. Elle sert avant tout à gagner du temps, à concentrer l’effort là où il est le plus efficace, et à éviter la dispersion. Ainsi, il n’est pas rare d’observer que : – 20 % des clients génèrent environ 80 % du chiffre d’affaires ; – 20 % des produits concentrent l’essentiel des ventes ou des stocks ; – une minorité de fonctionnalités d’un logiciel concentre la majorité des usages ; – une minorité de commandes génère la plupart des retards de livraison. … Dans ces situations, la règle des 80/20 n’est pas utilisée comme une loi exacte, mais comme une démarche opérationnelle : elle permet d’identifier rapidement les éléments dominants d’un système et de structurer l’action autour d’eux. Elle reflète une intuition largement partagée par les praticiens : les contributions ne sont pas réparties uniformément, et chercher à traiter tous les éléments de la même manière est souvent inefficace. Ce qui est frappant, toutefois, c’est la robustesse2 et la généralité de cette régularité. Bien au-delà des contextes managériaux, on retrouve des phénomènes similaires dans des domaines très différents : répartition des ventes culturelles, audiences médiatiques, tailles d’entreprises, parts de marché, fréquentation des plateformes numériques ou encore trafic sur Internet. Partout, une minorité d’éléments concentre une part disproportionnée des flux, tandis qu’une majorité reste marginale, sans être négligeable. Ces observations renvoient à deux caractéristiques structurelles majeures : – la concentration, où quelques acteurs ou objets dominent largement le système ; – la longue traîne, constituée d’une multitude d’éléments faiblement contributifs, mais dont l’ensemble peut représenter une masse significative. C’est précisément cette combinaison — domination de quelques-uns et étirement de la distribution — que la règle des 80/20 cherche à capturer de manière approximative. |

1. Pareto : de l’observation empirique à la forme mathématique des distributions de données

1.1 L’observation d’une régularité empirique

Lorsque Vilfredo Pareto3 étudie, à la fin du XIXᵉ siècle, la répartition des patrimoines dans plusieurs pays européens, son ambition n’est pas de formuler une loi universelle, encore moins une théorie normative de la justice sociale. Son approche est essentiellement empirique. En compilant des données fiscales et cadastrales, il constate que la distribution observée s’écarte systématiquement des formes statistiques alors utilisées pour décrire les phénomènes naturels ou sociaux.

Ce qui frappe Pareto n’est pas seulement l’existence d’écarts importants entre individus, mais la structure même de la distribution. Contrairement à une répartition symétrique autour d’une valeur moyenne, les données montrent une concentration marquée : une petite fraction de la population détient une part très élevée du patrimoine total, tandis qu’une majorité se répartit le reste selon une décroissance régulière. Cette forme se reproduit de manière remarquablement stable d’un pays à l’autre, indépendamment des contextes institutionnels ou historiques.

Pareto met ainsi en évidence une régularité statistique robuste, qui sera plus tard résumée — de manière simplificatrice — par la règle des 80/20. Mais son observation est plus générale : il s’agit d’une distribution sans échelle caractéristique, c’est-à-dire non représentable par des valeurs typiques qui la résument. Une distribution gaussienne (voir §1.2), par exemple, est résumée par sa moyenne et son écart-type qui mesure la dispersion autour de cette moyenne. Une distribution sans échelle (scale-free) est dominée par ses extrêmes et ne possède pas de taille, de richesse ou de fluctuation “typique”.

| Encadré historique : de Pareto aux lois de puissance Bien que Pareto ait observé la forte concentration des patrimoines, il n’a jamais formulé de loi mathématique générale. Le lien entre ses observations et les lois de puissance modernes a été établi progressivement : – George K. Zipf4 (1935) étudie la fréquence des mots dans les textes, découvrant une décroissance assimilable à une loi de puissance : dans un texte donné, la fréquence d’occurrence f(n) d’un mot est liée à son rang n dans l’ordre des fréquences par une loi de la forme f(n)=K/n où K est une constante. – Benoît Mandelbrot5, au début des années 1960, formalise mathématiquement des distributions en loi de puissance, montrant que les inégalités de revenus ou la distribution des tailles d’entreprises suivent des lois stables à queue lourde. – Barabási & Albert (voir §4) modélisent des réseaux en croissance avec attachement préférentiel, produisant naturellement des distributions en loi de puissance et des hubs, expliquant la concentration dans les systèmes sociaux, économiques et numériques. |

1.2 Loi normale, moyenne et illusion de représentativité

Pour comprendre la portée de cette observation, il est utile de la comparer aux distributions plus familières, notamment la loi normale (ou gaussienne, ces deux termes sont synonymes). Dans une distribution gaussienne, la majorité des observations se concentrent autour d’une moyenne qui résume efficacement le système. C’est le cas de la taille des adultes dans un pays, leur température corporelle, du nombre d’heures passées à la télé, des résultats au BAC etc. Les écarts extrêmes sont rares et jouent un rôle marginal. Ce type de distribution est bien adapté à des phénomènes où les fluctuations sont le résultat de nombreuses causes indépendantes et de faible amplitude.

Les distributions observées par Pareto, et plus tard dans de nombreux contextes économiques, sont de nature très différente. Elles se caractérisent par une queue longue, où les valeurs décroissent lentement. Dans ces distributions, la moyenne devient un indicateur fragile, parfois peu informatif, car une petite fraction des observations contribue de manière disproportionnée au total et qu’elle peut changer avec l’introduction d’un nouveau point extrême. On peut dénombrer beaucoup de petites villes et quelques mégalopoles énormes : la moyenne de la taille des villes dans un tel échantillon change beaucoup si on en rajoute une6…

1.3 Les lois de puissance expliquent les propriétés observées

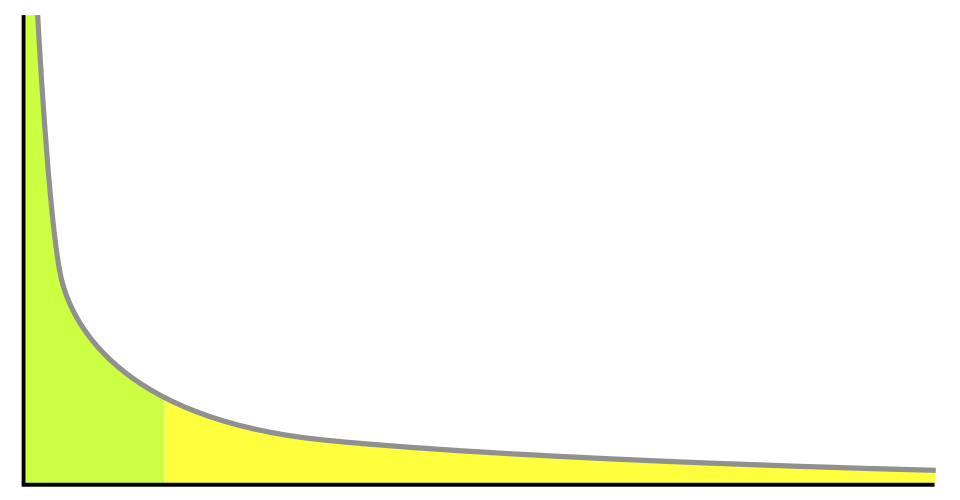

Pour comprendre pourquoi les distributions observées présentent à la fois concentration et longue traîne, il est utile de visualiser la forme d’une loi de puissance. Mathématiquement, une loi de puissance est une relation entre deux quantités x et y qui peut s’écrire de la façon suivante : y=axk où a est une constante dite constante de proportionnalité, k, valeur négative, est une autre constante, dite exposant, puissance, indice ou encore degré de la loi et x nombre réel strictement positif. Voici un graphique et son commentaire issus de Wikipedia.

La distribution d’une loi de puissance, correspondant par exemple à un classement de popularité des sites web (en ordonnée le classement d’un site, en abscisse les sites classés par ordre décroissant de popularité). À gauche, la zone verte illustre le principe des 80-20. (20% des sites cumulent 80 % des visites). À droite la queue de la distribution illustre l’effet “longue traîne”.

Quelques propriétés pédagogiques importantes expliquent ce que Pareto avait observé :

- Absence d’échelle caractéristique

Contrairement à la loi normale, une loi de puissance n’a pas, comme on l’a dit, de moyenne typique qui résume l’ensemble des valeurs. Des caractéristiques robustes comme la médiane peuvent être définies7, mais elles ne capturent pas l’essentiel du phénomène. Les valeurs les plus élevées (super-riches, blockbusters, hubs d’un réseau) jouent un rôle dominant. La concentration extrême est donc structurelle. - Longue traîne

La décroissance lente de y=axk implique que de nombreuses observations de faible amplitude coexistent avec quelques valeurs très élevées. La traîne de la distribution s’étend très loin, ce qui rend possible la coexistence simultanée de super-dominants et d’une multitude de participants marginaux. - Stabilité sous agrégation

La forme de la loi de puissance se conserve souvent lorsqu’on combine plusieurs ensembles similaires (d’où le terme “autosimilaire” dont on verra au § suivant l’application aux fractales). Cela explique pourquoi Pareto a retrouvé la même structure dans différents pays ou contextes économiques : les mécanismes locaux de croissance et d’accumulation produisent une régularité statistique robuste au niveau global.

1.4 Lois de puissance et fractales

Les lois de puissance sont intimement liées à la notion de fractale. Une distribution en loi de puissance est dite auto-similaire, car la forme de la distribution se répète à différentes échelles : qu’on considère les plus grands patrimoines ou les plus petits, le rapport entre les rares valeurs élevées et la multitude de valeurs modestes suit la même règle statistique. Cette propriété explique pourquoi la concentration et la longue traîne coexistent dans presque tous les systèmes observés — marchés, réseaux sociaux ou ventes culturelles — et pourquoi des patterns similaires apparaissent dans des domaines très différents. Même si les fractales ne sont pas le sujet de cette note, elles fournissent une intuition visuelle forte : les systèmes économiques dominés par des lois de puissance sont, à leur manière, autosimilaires et hiérarchiquement organisés.

Reste à comprendre maintenant comment cette forme émerge dynamiquement dans des contextes où les agents interagissent et se sélectionnent mutuellement. C’est l’objet du chapitre suivant.

2. “The Winner takes all” : dynamiques de concentration dans l’économie de l’attention

Les distributions de type parétien se manifestent avec une clarté particulière dans les domaines où la ressource fondamentale est l’attention. Parce que celle-ci est cumulative et auto-renforçante, elle tend à se concentrer sur quelques acteurs, qui accaparent l’essentiel du temps d’écoute, de la visibilité médiatique ou de l’audience. La concentration observée relève alors d’une dynamique de type « winner takes all”

Cette expression ne signifie pas que le gagnant capte littéralement tout, mais que les premiers captent beaucoup plus que les suivants, et ce de manière disproportionnée. Les écarts entre les leaders et le reste de la distribution sont sans commune mesure avec les différences observées dans des systèmes plus homogènes. Une œuvre légèrement plus visible peut générer un succès massif, tandis que des productions proches en qualité restent marginales.

Comment expliquer que des différences initiales relativement modestes produisent, au fil du temps, des écarts aussi extrêmes ? La réponse ne se trouve pas uniquement dans la qualité intrinsèque ou dans le talent, mais dans la dynamique même des systèmes d’attention.

2.1 Les exemples du cinéma, des livres, de la musique et des superstars

L’industrie cinématographique offre un exemple emblématique de cette dynamique. Chaque année, des centaines de films sortent sur les écrans, mais une poignée d’entre eux réalise l’essentiel du box-office mondial. Ces blockbusters ne se contentent pas de réussir un peu mieux que les autres : ils dominent largement l’ensemble du marché.

Plusieurs mécanismes se combinent. Les budgets marketing sont concentrés sur quelques titres, ce qui accroît leur visibilité initiale. Le succès en salle génère une couverture médiatique accrue, qui renforce à son tour la fréquentation. Les plateformes de recommandation, les classements hebdomadaires et le bouche-à-oreille amplifient encore ces effets. Le résultat est une distribution très étirée : quelques films8 concentrent la majorité des recettes, tandis qu’une longue traîne de productions reste faiblement visible.

Des mécanismes analogues sont à l’œuvre dans l’édition et la musique. Dans le secteur du livre, les listes de best-sellers jouent un rôle central. Une fois qu’un ouvrage entre dans ces classements, il bénéficie d’une exposition accrue en librairie, sur les plateformes en ligne et dans les médias. Cette visibilité supplémentaire augmente les ventes, ce qui consolide sa position dans les classements. Le processus est circulaire.

La musique amplifie encore cette logique, notamment avec le streaming. Les plateformes mettent en avant les titres déjà populaires, via des playlists éditoriales ou algorithmiques. Les morceaux les plus écoutés sont davantage recommandés, ce qui accroît encore leur audience. Là encore, une minorité d’artistes concentre une part considérable des écoutes mondiales, tandis que la majorité demeure dans une longue traîne faiblement monétisée.

Ce phénomène conduit à l’émergence de superstars, dont la visibilité dépasse largement celle de leurs concurrents, parfois indépendamment d’écarts proportionnels de qualité ou de productivité. Le succès devient un facteur de production à part entière.

2.2 L’économie de l’attention comme système cumulatif

Ce qui unifie ces exemples, c’est la présence de boucles de rétroaction positives. La visibilité engendre l’attention, l’attention engendre la visibilité. Chaque succès augmente la probabilité de succès futur. Dans un tel contexte, l’histoire compte : l’ordre d’arrivée, les premiers succès et les trajectoires initiales ont un impact durable.

L’économie de l’attention fonctionne ainsi comme un système cumulatif, dans lequel les distributions de résultats prennent naturellement la forme de lois de puissance. Les phénomènes de “winner takes all” ne sont pas des anomalies à corriger ponctuellement, mais des conséquences structurelles de la manière dont l’information, la visibilité et les choix individuels interagissent.

Pour passer de ce constat empirique à une compréhension plus formalisée, il faut identifier les mécanismes élémentaires à l’œuvre dans ces dynamiques cumulatives. Le chapitre suivant s’attache à expliciter l’un de ces mécanismes fondamentaux, l’attachement préférentiel, souvent résumé par l’idée simple : « le succès appelle le succès ».

3. L’attachement préférentiel : le succès comme dynamique

Dans le chapitre précédent, le succès a été décrit à travers ses résultats : parts de marché, audiences, ventes, visibilité. Ces indicateurs donnent une image statique des hiérarchies observées. Mais pour comprendre pourquoi ces hiérarchies prennent une forme aussi marquée et persistante, il faut déplacer l’analyse vers les processus dynamiques qui les produisent.

L’idée centrale de l’attachement préférentiel est la suivante : la probabilité de succès futur dépend du succès passé. Autrement dit, le succès n’est pas seulement une conséquence de caractéristiques intrinsèques, il devient lui-même un facteur causal. Cette logique transforme des différences initiales, parfois modestes, en écarts durables et cumulés.

Ce principe a été formulé sous différentes appellations — avantage cumulatif, effet Matthieu9 — mais il renvoie toujours à la même intuition fondamentale : dans certains systèmes, la croissance est proportionnelle à la taille.

3.1 Processus multiplicatifs et amplification

Considérons un acteur — une entreprise, un artiste, un produit — objet d’un choix collectif. Si cet acteur est déjà connu, visible ou recommandé, il a davantage de chances d’être sélectionné à nouveau. Chaque choix renforce sa position relative, ce qui accroît encore la probabilité de choix futurs. La dynamique est circulaire.

Ce mécanisme ne suppose ni rationalité parfaite10 ni stratégie consciente. Il suffit que les décisions individuelles soient influencées, même faiblement, par des signaux de popularité ou de visibilité. Dans ce cas, l’agrégation de comportements locaux produit une dynamique globale fortement asymétrique.

L’attachement préférentiel peut ainsi être compris comme une règle probabiliste minimale : plus un acteur est déjà choisi, plus il est susceptible de l’être à nouveau. Cette règle suffit à générer des hiérarchies très inégalitaires.

Un élément clé de l’attachement préférentiel est le rôle de l’information imparfaite11. Dans des environnements complexes, les agents ne peuvent pas évaluer exhaustivement toutes les options disponibles. Ils s’appuient sur des signaux simplificateurs : popularité, réputation, classement, notoriété. Ces signaux ne sont pas neutres. Ils reflètent l’histoire passée du système et orientent les choix futurs. En ce sens, l’attachement préférentiel peut être vu comme une conséquence naturelle d’une rationalité limitée12 : lorsque l’information est coûteuse, suivre ce qui est déjà populaire devient une stratégie raisonnable, bien que collectivement amplificatrice.

3.2 Limites et contre-mécanismes

Pris isolément, l’attachement préférentiel conduit à une concentration extrême. Or, les systèmes réels présentent souvent des contre-mécanismes : saturation des marchés, contraintes de capacité, obsolescence, régulation, coûts d’entrée ou innovations disruptives. Ces facteurs modèrent, sans l’annuler, la dynamique cumulative.

L’attachement préférentiel n’est pas une description exhaustive, mais un mécanisme de base, susceptible d’être enrichi par d’autres hypothèses. Mais pour aller au-delà de l’intuition, l’attachement préférentiel et ses contre-mécanismes doivent être inscrits dans une structure explicite. Celle des réseaux s’est révélée particulièrement adaptée et féconde. Dans un réseau en croissance, chaque nouvel acteur établit des liens avec des acteurs existants. Si la probabilité de créer un lien dépend du nombre de liens déjà existants, alors l’attachement préférentiel devient une règle de construction du réseau.

C’est dans ce cadre que le modèle de Barabási–Albert apporte une contribution décisive. Il montre qu’un mécanisme d’attachement préférentiel, combiné à une croissance progressive du réseau, suffit à produire des structures dominées par quelques hubs et une longue traîne de nœuds faiblement connectés.

4. Le modèle de Barabási–Albert : l’émergence des réseaux “scale-free”

4.1 Pourquoi passer par les réseaux ?

Les mécanismes décrits jusqu’ici — concentration, longue traîne, attachement préférentiel — appellent une représentation capable de relier des interactions locales simples à des structures globales observables. La notion de réseau fournit ce cadre. Dans un réseau, les entités (entreprises, œuvres, individus, plateformes) sont représentées par des nœuds (les sommets d’un graphe représentant le réseau), et leurs relations (transactions, recommandations, citations, collaborations) par des liens.

Cette représentation permet de dépasser une approche purement agrégée des marchés ou des audiences. Elle rend explicite la manière dont la visibilité, l’influence ou la position d’un acteur dépendent de sa place dans un ensemble de relations. Dans ce langage, le succès se traduit par un grand nombre de connexions, et la concentration par l’existence de hubs — des nœuds beaucoup plus connectés que la moyenne.

C’est dans ce cadre que s’inscrit le modèle proposé en 1999 par Albert-László Barabási et Réka Albert13, initialement pour décrire la structure du Web, mais dont la portée dépasse largement ce contexte.

4.2 Les deux hypothèses fondatrices

Le modèle de Barabási–Albert repose sur deux hypothèses seulement. La première est la croissance du réseau : le système n’est pas figé : de nouveaux nœuds apparaissent progressivement. Dans un contexte économique, cela correspond à l’entrée de nouvelles entreprises, de nouveaux produits, de nouveaux créateurs ou de nouvelles œuvres.

La seconde est l’attachement préférentiel. Lorsqu’un nouveau nœud arrive, il ne se connecte pas au hasard. Il a une probabilité plus élevée de se relier aux nœuds déjà bien connectés. Autrement dit, les acteurs déjà visibles attirent plus facilement de nouvelles relations.

Ces deux hypothèses sont empiriquement plausibles et ne supposent ni coordination centrale ni rationalité parfaite. Elles traduisent simplement le fait que, dans un environnement complexe, les nouveaux entrants s’orientent vers ce qui est déjà visible ou reconnu.

4.3 Les réseaux “invariants d’échelle”14 (ou scale-free)

À partir de ces hypothèses, le modèle produit un résultat remarquable : la distribution du nombre de connexions par nœud suit une loi de puissance (d’exposant -3). Cela signifie que le réseau ne possède pas d’échelle caractéristique. La majorité des nœuds possède peu de liens, tandis qu’une minorité en concentre un très grand nombre. Ces nœuds fortement connectés jouent un rôle structurant : ce sont les hubs du réseau. Leur présence n’est pas le résultat d’un choix délibéré ou d’une optimisation globale, mais l’issue naturelle d’une dynamique cumulative. Cette structure est observée empiriquement dans de nombreux systèmes économiques et culturels.

| Le modèle de Barabási–Albert : principe de la démonstration 1. Construction du modèle On part d’un petit réseau initial contenant quelques nœuds reliés entre eux. À chaque étape, un nouveau nœud est ajouté au réseau ; il crée m liens vers des nœuds déjà présents ; le choix des nœuds à connecter n’est pas aléatoire. 2. Attachement préférentiel La probabilité qu’un nouveau lien se connecte à un nœud donné dépend du nombre de liens déjà possédés par ce nœud. Si un nœud a un degré k (c’est-à-dire k connexions avec d’autres noeuds), alors la probabilité Π(k) qu’il reçoive un nouveau lien est proportionnelle à ce degré : Cela signifie simplement qu’un nœud deux fois plus connecté qu’un autre a deux fois plus de chances d’attirer un nouveau lien. Le dénominateur sert à normaliser pour que la somme des probabilités fasse 1. 3. Évolution du nombre de connexions d’un nœud Considérons un nœud i introduit à l’instant tiÀ chaque nouvel ajout de nœud, m nouveaux liens sont créés et le nœud i peut en recevoir une fraction. On peut alors écrire, en moyenne : Or, chaque lien ajoute deux extrémités au réseau, donc : Ce qui donne : 4. Résolution et interprétation Cette équation différentielle se résout aisément : Cela veut dire que plus un nœud est ancien, plus il a eu le temps d’accumuler des liens et que cette croissance suit une loi de puissance, et non une croissance linéaire. 5. Distribution des degrés (on nombre de connexions) On s’intéresse maintenant au nombre de nœuds ayant un degré donné k. En inversant la relation précédente, on obtient que la probabilité P(k) qu’un nœud ait un degré k vérifie : Cela signifie que les grands degrés sont rares mais pas exceptionnellement rares et qu’-il n’existe pas de degré typique : le réseau est sans échelle (scale-free). 6. Logique globale de la démonstration La démonstration repose sur une chaîne logique simple : 1. le réseau croît dans le temps ; 2. l’attachement préférentiel favorise les nœuds déjà connectés ; 3. cette règle produit une équation de croissance proportionnelle au degré ; 4. cette croissance mène naturellement à une loi de puissance ; 5. les hubs émergent sans planification centrale. |

Un aspect essentiel du modèle de Barabási–Albert est le rôle de l’histoire dans le processus. Les premiers nœuds bénéficient d’un avantage structurel : étant présents plus tôt, ils ont plus d’occasions d’accumuler des connexions. Cet effet d’antériorité peut conduire à des trajectoires très différentes à partir de conditions initiales proches.

Cette dépendance au sentier15 (path dependence) implique que les positions dominantes ne sont pas nécessairement le reflet d’une supériorité intrinsèque durable. Elles peuvent résulter de circonstances initiales favorables, amplifiées par la dynamique du réseau. Une fois établies, ces positions sont difficiles à contester, car les hubs attirent mécaniquement une part disproportionnée des nouvelles connexions.

4.4 Limites et extensions du modèle de B-A

Malgré sa puissance explicative, le modèle de Barabási–Albert reste très simplifié. Pris isolément, il tend à produire une concentration croissante sans borne. Or, les systèmes réels sont soumis à des contraintes supplémentaires : saturation de la demande, coûts croissants, régulation, innovation, obsolescence.

Pour tenir compte de ces éléments, plusieurs extensions ont été proposées : introduction de caractéristiques intrinsèques (fitness), plafonnement de l’attachement préférentiel, coûts de connexion ou mécanismes de vieillissement des nœuds. Ces variantes conservent la logique fondamentale du modèle tout en la rendant plus réaliste. (voir encadré).

| Extensions du modèle de Barabási–Albert : vers des réseaux plus réalistes Dès le début des années 2000, de nombreuses extensions ont été proposées au modèle Barabasi-Albert afin de mieux rendre compte de la diversité des réseaux observés dans le monde réel, tout en conservant la logique fondamentale du modèle. 1. Introduction de caractéristiques intrinsèques : les modèles à fitness Idée générale Dans le modèle de Barabási–Albert, tous les nœuds sont supposés équivalents au moment de leur apparition. Leur succès futur dépend uniquement de leur ancienneté et du nombre de liens déjà accumulés. Or, dans de nombreux contextes réels, certains nœuds possèdent des qualités intrinsèques qui les rendent plus attractifs que d’autres : qualité scientifique d’un article, pertinence d’un site web, talent d’un individu, etc. Les modèles à fitness introduisent cette hétérogénéité en attribuant à chaque nœud une capacité propre à attirer des connexions, indépendante de son âge. Résultats majeurs16 Ces modèles montrent qu’un nœud apparu tardivement peut devenir central s’il possède une fitness élevée, que l’ancienneté n’est plus la seule source d’avantage cumulatif et que, dans certains cas extrêmes, un seul nœud peut capter une fraction dominante des liens du réseau (phénomène de « winner takes all »). 2. Limitation ou modification de l’attachement préférentielIdée générale. Dans le modèle de Barabási–Albert, plus un nœud est connecté, plus il attire de nouvelles connexions, sans limite. Or, dans de nombreux réseaux réels, cette croissance peut être freinée par des contraintes cognitives ou organisationnelles, des limites techniques ou par des mécanismes institutionnels. Principales variantes Deux types de modifications ont été étudiés : – l’introduction d’une attractivité minimale, garantissant que même les nœuds peu connectés puissent attirer des liens ; – la modification de la manière dont la popularité influence l’attractivité, ce qui peut renforcer ou, au contraire, atténuer la domination des hubs. Résultats principaux17 Selon la variante considérée, les inégalités de connexions peuvent être réduites ou au contraire accentuées jusqu’à la domination quasi totale d’un petit nombre de nœuds ; la distribution des degrés peut s’écarter de la loi de puissance classique. 3. Coûts de connexion et contraintes de capacité Idée générale Dans les réseaux réels, créer ou maintenir une connexion a souvent un coût : temps, énergie, ressources financières, attention. Certains modèles introduisent explicitement ces coûts afin de limiter la croissance illimitée des hubs. Effets observés18 L’introduction de coûts ralentit la concentration excessive des liens, favorise une structure plus équilibrée et peut conduire à l’apparition de plusieurs hubs de taille intermédiaire plutôt qu’un petit nombre de super-hubs. Ces modèles sont particulièrement pertinents pour les réseaux économiques, biologiques ou sociau 4. Vieillissement des nœuds (aging)Idée générale. Dans de nombreux réseaux, l’attractivité d’un nœud diminue avec le temps. Les articles scientifiques sont moins cités lorsqu’ils deviennent anciens, les technologies obsolètes perdent leur attractivité et l’attention collective se déplace vers la nouveauté. Les modèles avec vieillissement introduisent un mécanisme par lequel la capacité d’un nœud à attirer de nouveaux liens décroît au cours du temps. Conséquences19 Ces modèles montrent que les hubs ont une durée de vie limitée, les structures de domination sont moins stables et la dynamique du réseau devient plus proche des observations empiriques. 5. Fermeture triadique20 et formation de communautés Idée générale Le modèle de Barabási–Albert produit peu de triangles et donc peu de communautés locales, contrairement aux réseaux sociaux réels. Des modèles hybrides combinent l’attachement préférentiel avec une tendance à se connecter aux voisins de ses voisins, renforçant ainsi la cohésion locale. Résultat21 On obtient des réseaux qui conservent une forte hétérogénéité des degrés, présentent un fort regroupement communautaire et ressemblent davantage aux réseaux sociaux observés. Conclusion Les extensions du modèle de Barabási–Albert permettent de mieux représenter les réseaux observés empiriquement mais que la logique de l’attachement préférentielle reste centrale pour expliquer l’avantage cumulatif . |

5. Bulles financières, queues épaisses et dynamiques cumulatives

Dès les origines de la finance moderne, les trajectoires de prix des actifs ont été modélisés comme des mouvements browniens22 : une succession de variations aléatoires, indépendantes, de faible amplitude, dont la distribution est approximativement normale. Cette hypothèse, centrale dans la théorie financière classique (Bachelier, puis Black et Scholes), implique que les variations extrêmes sont rares, que les risques sont bien résumés par la variance, et que les crises majeures relèvent de l’exception.

Or, cette représentation est contredite de manière systématique par les données empiriques. Les séries temporelles de prix boursiers présentent des variations extrêmes beaucoup plus fréquentes que prévu, des épisodes de forte volatilité persistante, et des ruptures brutales caractéristiques des krachs et des bulles.

Autrement dit, les marchés financiers ne sont pas dominés par de petites fluctuations indépendantes, mais par des événements rares et massifs, analogues aux extrêmes observés dans les distributions de patrimoine, de succès ou de taille d’entreprise.

5.1 Benoît Mandelbrot et les queues épaisses en finance

C’est Benoît Mandelbrot, dès les années 1960, qui établit explicitement le lien entre finance et lois de puissance (voir encadré page 5). En étudiant les variations des prix du coton puis des actifs financiers, il montre que leur distribution suit des lois à queue lourde, incompatibles avec la loi normale. Les implications sont profondes : les grandes variations ne sont pas des anomalies, la variance peut être mal définie ou instable, et le risque systémique est structurel, non accidentel.

Les marchés financiers rejoignent ainsi la famille des systèmes dominés par des lois de puissance, où quelques événements concentrent une part disproportionnée de l’impact total — exactement comme quelques individus concentrent la richesse ou quelques œuvres concentrent l’attention.

Les études empiriques ultérieures23 ont largement montré que les séries de rendements d’actifs financiers sont des distributions fortement non gaussiennes, à queues épaisses, aux dépendances temporelles fortes pour la volatilité, etc. Elles montrent que ces propriétés communes à de nombreux marchés remettent en question les hypothèses classiques (marche aléatoire, normalité).

Les bulles financières24 peuvent être interprétées comme une forme dynamique extrême du succès cumulatif. Leur mécanisme repose sur une logique proche de celle décrite dans les chapitres précédents : une hausse initiale d’un cours attire l’attention, qui attire de nouveaux acheteurs, ce qui fait monter les prix. La hausse passée devient une justification de la hausse future.

Rappelons que dans le mouvement brownien, au contraire, les déplacements (ici les variations de cours) n’ont ni histoire ni mémoire : chaque déplacement est indépendant du précédent. Ce mécanisme proposé ici est donc radicalement différent puisqu’au contraire « le succès (une hausse de prix) y appelle le succès. Les anticipations deviennent auto-réalisatrices, et la dynamique se détache progressivement des fondamentaux économiques.

Comme dans les réseaux scale-free, quelques actifs, secteurs ou narratifs deviennent des hubs financiers, concentrant flux de capitaux et attentes.

5.2 Auto-similarité, temporalité des crises et éclatement des bulles

Un autre point de contact fort avec les lois de puissance réside dans la structure temporelle des marchés. Les séries financières présentent une auto-similarité : les mêmes motifs statistiques apparaissent à différentes échelles de temps (minutes, jours, années). Cette propriété est caractéristique des processus fractals (voir §1.4), tels que les a étudiés Mandelbrot.

Cela explique pourquoi des mini-bulles et mini-krachs coexistent avec de grandes crises, les marchés semblent calmes pendant longtemps, puis basculent brutalement. Au total la fréquence des crises majeures est bien plus élevée que ne le prédit un modèle brownien. Les bulles ne sont donc pas des accidents isolés, mais des manifestations naturelles d’un système à dynamique non linéaire, dominé par des rétroactions positives.

Dans un cadre brownien ou d’équilibre général, une bulle éclatée devrait conduire à un retour rapide vers une valeur fondamentale. Or, empiriquement, les krachs sont brutaux, asymétriques et suivis de phases longues de réorganisation. Cette asymétrie est typique des systèmes à loi de puissance : la montée est graduelle et cumulative, la chute est rapide et collective. Elle rappelle la dynamique des systèmes critiques ou la perte de connectivité dans les réseaux lorsque les hubs s’effondrent.

Les marchés financiers apparaissent ainsi comme des systèmes hors équilibre, proches de la criticité, où l’instabilité est endogène.

6. L’industrie pharmaceutique

Dans l’industrie pharmaceutique, une petite minorité de médicaments génère une part disproportionnée des ventes totales, un schéma que l’on désigne sous le terme de “modèle blockbuster”25.

Historiquement, ce modèle a structuré la stratégie des grandes firmes : quelques produits à très fortes ventes couvrent les coûts immenses de recherche et développement et financent l’activité globale. Bien que les données détaillées par produit ne permettent pas toujours de tester formellement une loi de puissance au sens strict, la forte concentration observée — que ce soit avec des blockbusters classiques comme le Lipitor (nom commercial aux USA de l’atorvastatine, un “anticholestérol” ) ou des produits très largement prescrits comme le Doliprane — est cohérente avec des distributions très inégales similaires à celles observées dans d’autres industries de biens populaires.

Le succès d’un médicament résulte de l’interaction entre sa qualité intrinsèque et des dynamiques de rendements croissants. Dans le cas de l’imatinib, destiné à la leucémie myéloïde chronique, son efficacité exceptionnelle et sa spécificité scientifique ont favorisé une adoption rapide et quasi totale dès son introduction. Pour le Doliprane, le succès s’est construit plus progressivement : l’élargissement de ses indications et sa toxicité plus faible que celle de l’aspirine ont renforcé son adoption, soutenue par des mécanismes cumulés comme la confiance des patients et l’habitude des prescriptions. L’aspirine illustre quant à elle l’effet du repositionnement thérapeutique : à très faible dose, elle est aujourd’hui utilisée pour des indications qui étaient inconnues au moment de sa mise sur le marché, générant un regain d’intérêt et de prescriptions. Dans tous ces cas, ces mécanismes — qualité intrinsèque, adoption cumulative et repositionnement — produisent une concentration marquée de l’usage et de la notoriété, conformément à un schéma typique de loi de puissance : quelques médicaments captent l’essentiel des prescriptions, tandis que la majorité reste marginale.

7. De la concentration des réseaux à la formation des oligopoles

Dans l’analyse économique classique, l’oligopole est souvent présenté comme une structure de marché particulière, située entre la concurrence parfaite et le monopole. Il est généralement expliqué par des barrières à l’entrée, des économies d’échelle, ou des comportements stratégiques des firmes en place. Cette lecture ne rend pas pleinement compte de la régularité empirique avec laquelle les oligopoles apparaissent dans des secteurs très différents.

Si l’on considère les marchés comme des réseaux en croissance, dans lesquels les entreprises nouent des relations avec des clients, des fournisseurs, des partenaires ou des utilisateurs, alors l’oligopole peut être compris comme une structure émergente, résultant de dynamiques cumulatives plutôt que d’une stratégie concertée ou de collusions. Cette lecture ne disculpe pas les pratiques anticoncurrentielles lorsqu’elles existent, mais elle démontre que la structure du marché elle-même peut produire de la concentration, indépendamment des intentions des acteurs.

Dans ce cadre, les entreprises dominantes apparaissent comme des hubs économiques : elles concentrent les flux, l’information et l’attention, tandis qu’une multitude d’acteurs périphériques coexistent dans une longue traîne.

7.1 Attachement préférentiel et parts de marché

Appliqué aux marchés, le mécanisme d’attachement préférentiel est intuitif. Les entreprises déjà bien établies attirent plus facilement de nouveaux clients, car elles bénéficient d’une notoriété plus élevée, d’un réseau de distribution plus dense ou d’une base d’utilisateurs existante. Chaque nouveau client renforce leur position et accroît encore leur attractivité relative.

Ce processus est particulièrement puissant lorsque les choix des consommateurs sont influencés par des signaux sociaux : recommandations, classements, parts de marché visibles, effets de réputation. Dans ces conditions, la probabilité de choisir un acteur dépend non seulement de ses caractéristiques intrinsèques, mais aussi de sa position actuelle dans le réseau. La conséquence est une dynamique de concentration progressive, où quelques acteurs captent une part croissante du marché, sans qu’il soit nécessaire d’invoquer des comportements anticoncurrentiels explicites.

7.2 Rendements croissants et effets de réseau

Les rendements croissants jouent un rôle central dans cette dynamique. Lorsqu’une entreprise bénéficie d’économies d’échelle, le coût moyen diminue avec la taille, ce qui renforce l’avantage des acteurs déjà dominants. De même, les effets de réseau font que la valeur d’un produit ou d’un service augmente avec le nombre d’utilisateurs, comme c’est le cas pour les plateformes numériques, les systèmes de paiement ou les standards technologiques. Dans un tel contexte, l’attachement préférentiel est renforcé par des mécanismes économiques tangibles. Les nouveaux entrants ne se heurtent pas seulement à la notoriété des acteurs en place, mais aussi à des désavantages structurels. La concentration devient alors auto-entretenue.

Ces mécanismes expliquent pourquoi de nombreux marchés tendent vers des structures oligopolistiques stables, dominées par un petit nombre d’acteurs, tandis que la concurrence se joue essentiellement à la périphérie.

Cette lecture ne disculpe pas les pratiques anticoncurrentielles lorsqu’elles existent, mais elle rappelle que la structure du marché elle-même peut produire de la concentration, indépendamment des intentions des acteurs.

7.3 La régulation des oligopoles

Reconnaître le caractère structurel des oligopoles ne conduit pas au fatalisme. Les extensions du modèle de Barabási–Albert montrent que des mécanismes tels que les coûts, le vieillissement, la saturation ou la régulation peuvent modérer la concentration et favoriser le renouvellement des acteurs dominants.

La question centrale devient alors celle du design institutionnel : comment introduire des frictions, des limites ou des incitations qui préservent les bénéfices des réseaux tout en évitant une concentration excessive et durable ? Cette interrogation dépasse le cadre de cette note, mais elle souligne l’intérêt pratique d’une compréhension fine des dynamiques à l’œuvre.

8. La remise en cause de la théorie de l’équilibre général et de l’ efficience des marchés

La théorie de l’équilibre général, formalisée par Walras puis par Arrow et Debreu, repose sur un ensemble d’hypothèses fortes : agents atomistiques, interactions indirectes via les prix, rendements non croissants, information parfaitement diffusée et marchés complets. Dans ce cadre abstrait, et bien loin des réalités empiriques, l’économie converge vers un état d’équilibre unique, stable et efficient au sens de Pareto.

Cette construction repose en particulier sur une vision très particulière de la structure des interactions économiques, implicitement lisse, homogène et faiblement hiérarchisée. L’introduction des lois de puissance et des structures en réseau, bien plus réalistes, remet en cause profondément ces hypothèses, comme nous allons le voir.

Dans de nombreux marchés réels — financiers, culturels, industriels — les agents ne sont ni équivalents ni interchangeables. Quelques acteurs concentrent parts de marché, information, liquidité ou attention. Ces configurations correspondent à des réseaux hautement hétérogènes, souvent de type scale-free, incompatibles avec l’hypothèse d’agents de taille négligeable. Dans ces systèmes, les interactions ne passent plus uniquement par les prix, mais par des liens directs : imitation, réputation, dépendance technologique, exposition financière. L’économie n’est plus un ensemble d’agents isolés coordonnés par un système de prix abstrait, mais un réseau d’interactions asymétriques. Concernant les prix eux-mêmes les entreprises dominantes sont des price makers et les autres (la grande majorité des price takers.

Les lois de puissance émergent précisément lorsque le succès passé augmente la probabilité du succès futur. Effets de réseau, économies d’échelle dynamiques, visibilité cumulative introduisent des rendements croissants endogènes, explicitement exclus par hypothèse dans les modèles standards d’équilibre général. Dans les marchés financiers, la liquidité attire la liquidité ; dans les oligopoles, la taille attire la taille. Ces mécanismes produisent des dynamiques de concentration auto-renforcées qui éloignent structurellement le système de l’équilibre concurrentiel.

Lorsque les interactions sont non linéaires et les rendements croissants, l’unicité et la stabilité de l’équilibre ne sont plus garanties. Les systèmes peuvent présenter des équilibres multiples, des transitions brutales et des phases d’instabilité persistante. La formation d’oligopoles comme celle des bulles financières vues au chapitre précédent apparaissent alors non comme des anomalies temporaires, mais comme des états dynamiques endogènes du système. L’équilibre cesse d’être un attracteur naturel et devient, au mieux, une configuration locale et transitoire.

Comme on l’a vu, dans les systèmes dominés par des lois de puissance, la moyenne ne décrit plus le système. Une minorité d’acteurs ou d’événements détermine l’essentiel des résultats globaux. Or l’équilibre général repose sur des agrégations supposées représentatives des comportements microéconomiques et des comportements moyens, qui deviennent trompeurs lorsque les distributions sont dominées par leurs extrêmes. L’agent représentatif26, pilier implicite de nombreux raisonnements d’équilibre, perd toute pertinence analytique.

L’hypothèse d’efficience des marchés (Efficient Market Hypothesis, EMH), formalisée par Eugene Fama, affirme que les prix des actifs incorporent instantanément toute l’information disponible. Elle repose sur des hypothèses proches de celles de l’équilibre général : diffusion parfaite de l’information, agents rationnels, rendements distribués normalement, trajectoires assimilables à un mouvement brownien.

L’approche par les lois de puissance et les réseaux invalide cette hypothèse sur plusieurs plans fondamentaux. Dans un marché structuré en réseau, l’information ne se diffuse pas instantanément mais localement, le long de liens sociaux, institutionnels et technologiques. Certains acteurs jouent le rôle de hubs informationnels, générant délais, amplifications et contagions. Les rendements financiers présentent des queues épaisses : les événements extrêmes ne sont ni rares ni négligeables, mais structurants. Les prix dépendent de leur propre histoire : dans les modèles à attachement préférentiel, la performance passée accroît la probabilité de succès futur. Les bulles deviennent endogènes, non accidentelles.

Dans les systèmes en loi de puissance, l’instabilité n’est pas un dysfonctionnement temporaire, mais une propriété structurelle. Les marchés sont robustes aux petits chocs, mais fragiles aux perturbations touchant les acteurs centraux. Cette asymétrie est incompatible avec une vision d’équilibre informationnel global. Les lois de puissance et les réseaux remettent en cause fondamentalement l’équilibre général ou l’efficience comme représentations plausibles de la réalité économique. Dans des économies dominées par l’hétérogénéité, l’histoire et les interactions directes, l’équilibre devient local, instable et contingent. L’économie apparaît fondamentalement hors équilibre.

Conclusion générale

Les lois de puissance montrent que la concentration, les hubs et la longue traîne sont la norme, pas l’exception. Elles rappellent que :

- le succès est cumulatif et dépend des interactions, de l’histoire, mais aussi des qualités intrinsèques des éléments ou des acteurs ;

- la concentration et les oligopoles peuvent émerger même sans comportements collusifs ;

- les cadres classiques doivent être remplacés par des modèles dynamiques, de réseau et hors équilibre, capables de tenir compte à la fois de l’avantage cumulatif et des différences de “fitness” ou de valeur intrinsèque.

Cette perspective est particulièrement pertinente pour les marchés numériques, culturels, technologiques, pharmaceutiques…, où la visibilité, la prescription et les effets cumulatifs structurent la distribution des résultats. Elle invite à repenser la manière dont les ressources, l’attention, le succès économique et la diffusion des innovations se concentrent dans les systèmes modernes, en intégrant à la fois les mécanismes d’auto-renforcement et les qualités propres des produits ou des acteurs.

Alain Grandjean

NOTES

- En statistique , la queue ou traîne d’une loi de probabilité correspond à la portion éloignée de la « tête » ou valeur centrale de la loi. Le terme de longue traîne a été popularisé par Benoit Mandelbrot pour un article publié en 1951. Voir l’article Longue traine sur wikipedia; et cet interview : The father of long trails ↩︎

- La répartition 80/20 n’est bien sûr pas toujours précisément respectée. C’est une image ; ce qui est robuste c’est l’idée qu’une faible quantité d’éléments (ce peut être 5% ou 25%) ont une forte contribution (75% ou 95%). Les chiffres varient en fonction de l’exposant de la puissance de la loi. ↩︎

- Voir Cours d’économie politique. Vol. 1 / Vilfredo Pareto. – F. Rouge, 1896. ↩︎

- Voir l’article Loi de Zipf sur Wikipedia et Zipf, G.K. (1935), The Psycho-Biology of Language, Cambridge: MIT Press. ↩︎

- Mandelbrot, B.B. (1960), “The Pareto-Levy law and the distribution of income,” Int. Economic Review, 1(2), 79–106. et Mandelbrot, B.B. (1963), The Variation of Certain Speculative Prices, Journal of Business, 36(4), 394–419. ↩︎

- La même idée a été exprimée en imaginant Bernard Arnault rentrant dans un bar ce qui faisait exploser la moyenne des revenus (et des patrimoines) des présents. ↩︎

- Si l’exposant k est >1. ↩︎

- Ceci ne veut pas dire qu’il soit facile de prévoir lesquels ! ↩︎

- Selon Wikipedia “Le terme est dû au sociologue américain Robert King Merton qui, dans un article publié en 1988 cherche à expliquer comment les scientifiques et les universités les plus réputés maintiennent leur domination dans le domaine de la recherche. Cette appellation fait référence à une phrase de l’Evangile selon Matthieu : « Car on donnera à celui qui a, et il sera dans l’abondance, mais à celui qui n’a pas on ôtera même ce qu’il a ». Voir https://fr.wikipedia.org/wiki/Effet_Matthieu ↩︎

- En particulier l’ensemble des constatations faites ici sont inexplicables si l’on considère que l’ homo économicus est rationnel au sens de la théorie néoclassique. Mais nous savons bien que cette hypothèse de rationalité est infondée et sans rapport avec les réalités sociales bien mieux représentés par les modèles présentés ici. ↩︎

- L’information imparfaite désigne une situation où les acteurs économiques ou sociaux ne disposent pas de toutes les informations nécessaires pour prendre une décision optimale. L’information asymétrique est un cas particulier d’information imparfaite où certaines parties ont plus d’informations que d’autres (ex. : assureur vs assuré, vendeur vs acheteur). Voir Akerlof, G. A. (1970), The Market for « Lemons »: Quality Uncertainty and the Market Mechanism, Quarterly Journal of Economics, 84(3), 488–500. et Stiglitz, J. E. (2000), Economics of the Public Sector, 3rd edition, Norton. ↩︎

- La rationalité limitée (ou bounded rationality en anglais) est un concept en économie et en sciences sociales proposé par Herbert A. Simon dans les années 1950. Il désigne l’idée que, dans la prise de décision, les individus essaient de prendre les meilleures décisions possibles compte tenu de leurs connaissances limitées, de leurs capacités cognitives et des contraintes de temps. Autrement dit, les acteurs ne peuvent pas toujours optimiser parfaitement leurs choix car Ils ne disposent pas de toutes les informations nécessaires, leur capacité de traitement de l’information est limitée et Ils doivent souvent prendre des décisions rapidement. Voir Herbert A. Simon (1955), A Behavioral Model of Rational Choice, Quarterly Journal of Economics, 69(1), 99–118. ↩︎

- Barabási, A.-L., & Albert, R. (1999), “Emergence of scaling in random networks,” Science, 286, 509–512. ↩︎

- Voir également la page wikipédia à ce sujet. ↩︎

- La dépendance au sentier désigne le phénomène par lequel les décisions ou les résultats présents dépendent fortement des choix passés, même si ces choix initiaux ne sont plus optimaux aujourd’hui. Autrement dit : une fois qu’un processus, une technologie ou une institution a pris une certaine trajectoire, il devient difficile de changer de chemin, même si une meilleure alternative apparaît plus tard. Ce phénomène crée un effet de verrouillage (lock-in) : les acteurs restent « coincés » dans une trajectoire initiale. Une rigidité des systèmes : les systèmes sont moins flexibles et plus résistants au changement, même si des meilleures options existent. Et il met en évidence l’importance des choix initiaux : de petites décisions ou événements aléatoires peuvent avoir des conséquences majeures à long terme. Exemple classique : le clavier QWERTY , conçu pour ralentir la frappe mécanique, reste dominant malgré l’existence de dispositions plus efficaces. Voir Arthur, W. B. (1989), Competing Technologies, Increasing Returns, and Lock-In by Historical Events, The Economic Journal, 99(394), 116–131. ↩︎

- Voir Ginestra Bianconi & Albert-László Barabási (2001), Competition and multiscaling in evolving networks, Physical Review Letters et Guido Caldarelli et al. (2002) Scale-Free Networks from Varying Vertex Intrinsic Fitness, Physical Review Letters. ↩︎

- Voir S. N. Dorogovtsev, J. F. F. Mendes & A. N. Samukhin (2000)

Structure of Growing Networks with Preferential Linking, Physical Review Letters. et P. L. Krapivsky, S. Redner & F. Leyvraz (2000), Connectivity of Growing Random Networks, Physical Review Letters. ↩︎ - Voir Maral et al. (2000), Classes of Small-World Networks, Proceedings of the National Academy of Sciences. ↩︎

- Voir Dorogovtsev & Mendes (2000)

Evolution of Networks with Aging of Sites, Physical Review E. et Eom & Fortunato (2011)

Characterizing and Modeling Citation Dynamics, Physical Review E. Voir également https://en.wikipedia.org/wiki/Triadic_closure ↩︎ - La fermeture triadique est la propriété, en théorie des réseaux sociaux, selon laquelle s’il existe des liens forts entre deux individus et entre l’un de ces individus et un troisième individu, alors il existe également un lien (fort ou faible) entre le premier et le troisième individu. ↩︎

- Voir Petter Holme & Beom Jun Kim (2002) Growing Scale-Free Networks with Tunable Clustering, Physical Review E. ↩︎

- Louis Bachelier est le père des mathématiques financières. Il a eu l’idée d’utiliser en finance le mouvement brownien. Pour comprendre les limites de cette représentation voir le petit livre très éclairant de Michel de Pracontal et Christian Walter Le virus B , Crises financières et mathématiques. Le B est l’initial de Brownien… ↩︎

- Voir par exemple R. Cont Empirical properties of asset returns: stylized facts and statistical issues. Quantitative Finance, 2001, vol. 1, issue 2, 223-236 . Cet article présente et synthétise les “faits stylisés” observés empiriquement dans les séries de rendements d’actifs financiers. ↩︎

- Voir par exemple dans son livre, Sornette, D. (2003), Why Stock Markets Crash Critical Events in Complex Financial Systems, Didier Sornette applique la théorie des systèmes complexes pour expliquer que les krachs boursiers ne sont pas des événements totalement aléatoires mais résultent d’une instabilité endogène liée à la formation de bulles spéculatives par imitation et rétroactions positives entre investisseurs. Sornette argue que, comme dans les phénomènes physiques critiques, les marchés peuvent montrer des signaux précurseurs caractéristiques avant un effondrement (par exemple des lois de puissance avec log‑périodicité) et que ces signaux peuvent parfois être utilisés pour anticiper une crise. ↩︎

- Voir par exemple cet article de Philippe Abecassis et Nathalie Coutinet. Médicaments génériques : pivot de la reconstruction de l’industrie pharmaceutique ↩︎

- Un agent représentatif est, en science économique, un agent économique considéré comme moyen; La plupart des modèles macroéconomiques sont aujourd’hui caractérisés par un problème d’optimisation utilisant l’hypothèse d’agent représentatif pour le consommateur ou le producteur. Les courbes d’offre et de demande de ces agents sont ensuite interprétées comme étant l’offre et la demande agrégées de ces deux types d’agents.économique. ↩︎

Laisser un commentaire